مسئله از جایی شروع شد که کسی متوجهش نبود

هیچکدام از ما صبح از خواب بیدار نشدیم و تصمیم نگرفتیم جهانمان را به الگوریتمها بسپاریم.

اما بهنظر میرسد دقیقاً همین اتفاق، آرام و بیسروصدا در حال رخ دادن است.

هوش مصنوعی مولد با وعده سرعت، بهرهوری و کاهش هزینه، وارد رسانهها، سازمانها و تصمیمسازیها شده است. ابزارهایی که میتوانند بنویسند، تحلیل کنند و پیشنهاد بدهند، حالا در دسترس همه قرار دارند.

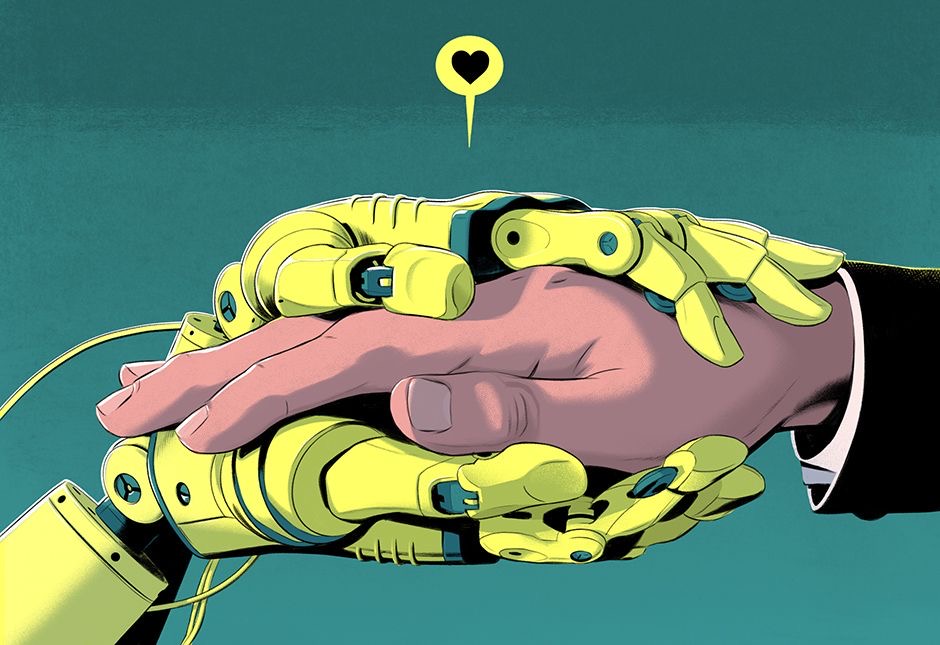

مسئله اما خودِ فناوری نیست؛ مسئله فاصلهای است که میان سرعت پیشرفت ابزارها و آمادگی انسانی برای استفاده مسئولانه از آنها ایجاد شده است.

این مقاله قرار نیست هوش مصنوعی را تطهیر کند یا از آن هیولا بسازد. هدف، بررسی یک پرسش مشخص است:

وقتی ابزار جلوتر از فهم حرکت میکند، نقش انسان کجاست و چه رویکردی میتواند ما را از تصمیمسپاری کورکورانه نجات دهد؟

هوش مصنوعی مولد چیست و چرا اینبار با گذشته فرق دارد؟

تا پیش از ظهور Generative AI، هوش مصنوعی عمدتاً نقش تحلیلگر داشت؛ دادهها را دستهبندی میکرد، الگو مییافت و پیشبینی میداد.

اما مدلهای زبانی بزرگ، این نقش را تغییر دادند.

از تحلیل داده تا تولید معنا

مدلهایی مانند GPT و Gemini قادرند متن، گزارش و سناریو تولید کنند؛ خروجیهایی که بهشکل نگرانکنندهای شبیه نوشتار انسانی هستند.

طبق گزارش Stanford AI Index 2024، سرعت پذیرش این مدلها در سازمانها بیسابقه بوده است [1].

مشکل اصلی کجاست؟ وقتی ابزار جلوتر از فهم حرکت میکند

چالش Generative AI صرفاً فنی نیست؛ چالش انسانی است.

توهم جایگزینی انسان

بسیاری از سازمانها، بهاشتباه، AI را جایگزین قضاوت انسانی میبینند، نه پشتیبان آن.

درحالیکه گزارش McKinsey Global Institute نشان میدهد بیشترین ارزش اقتصادی AI در کمک به تصمیمسازی انسانهاست، نه حذف آنها [2].

رسانهها؛ اولین قربانی یا اولین هشدار؟

رسانهها زودتر از دیگران با این شکاف مواجه شدند.

تولید سریع محتوا جذاب بود، اما مسئله اعتماد، صحت و مسئولیت بهسرعت خود را نشان داد.

بحران اعتماد عمومی

بر اساس Digital News Report مؤسسه Reuters، استفاده بدون چارچوب از AI در تحریریهها میتواند اعتماد مخاطب را تضعیف کند [3].

اینجا مسئله روشن میشود: AI بدون انسان، مسئلهساز است؛ نه نجاتدهنده.

دو واکنش اشتباه؛ ترس مطلق یا خوشبینی مطلق

برخورد جامعه با هوش مصنوعی معمولاً بین دو قطب در نوسان است:

- ترس از حذف انسان

- خوشبینی افراطی به حل همه مسائل

چرا هر دو خطرناکاند؟

گزارشهای سیاستگذاری OECD تأکید میکنند که AI باید «انسانمحور» طراحی شود، نه انسانزدا [4].

رویکرد انسانی پیشنهادی؛ مسئله را چگونه باید حل کرد؟

اگر بپذیریم که Generative AI آمده است که بماند، سؤال اصلی این نیست که «استفاده کنیم یا نه؟»

سه اصل برای استفاده مسئولانه

- AI باید همکار تحلیلگر باشد، نه تصمیمگیر نهایی

- خروجی AI باید شفاف و قابل تشخیص باشد

- مسئولیت نهایی همیشه با انسان بماند

در شرکت توسعه فناوریهای نوین رایانهای صبا، توسعه محصولاتی مانند BornaAI دقیقاً با همین رویکرد انجام شده است؛

AI بهعنوان ابزار پشتیبان تصمیم، نه جایگزین تفکر.

نتیجهگیری | مسئله آینده نیست، مسئله بلوغ است

هوش مصنوعی مولد آینده را نابود نمیکند.

این نحوه مواجهه ما با آن است که آینده را میسازد یا تخریب میکند.

سازمانها و رسانههایی که امروز برای نقش انسان تصمیم نمیگیرند، فردا مجبور میشوند هزینه تصمیم نگرفتن را بپردازند.

در عصر Generative AI، شاید مهمترین مهارت نه سرعت تولید، بلکه توان تشخیص مرز میان الگوریتم و مسئولیت انسانی باشد.

منابع

[1] Stanford University – AI Index Report 2024

[2] McKinsey Global Institute – The Economic Potential of Generative AI

[3] Reuters Institute – Digital News Report

[4] OECD – Artificial Intelligence and Trust